Was heute unter dem Begriff "Alignment" zusammengefasst wird, bezeichnet das Problem, wie man einer von Menschen entwickelten Maschine Moral beibringen kann. Das Dilemma dabei: Zum einen ist nicht immer trennscharf klar, was unter "Gut" und "Böse" zu verstehen ist - dass es also keine hundertprozentigen Verhaltensregeln gibt. Zum anderen können auch Menschen, die Schöpfer der Maschinen, willentlich gegen ihren Verhaltenscodex verstoßen, also "böse" sein - und diese Eigenschaft damit möglicherweise auch auf ihre Geschöpfe, die Maschinen, übertragen.

KI-Entwickler Altman: Geschichte der KI ist keine "nur gute"

Selbst KI-Entwickler wie Sam Altman, Chef des US-Softwareunternehmens OpenAI, das den Sprach-Bot ChatGPT programmiert hat, warnen immer wieder vor den Gefahren von KI. So sagte Altman bei einem Auftritt beim Chip-Entwickler Intel im Februar dieses Jahres, die Geschichte der KI werde keine "nur gute" sein. Gemeint sind zunächst ganz konkrete Gefahren. Der KI-Boom könne absehbar negative Auswirkungen auf Wahlen haben. Es drohten zum Beispiel auch Gefahren bei Cybersicherheit oder Biowaffen.

Eigenes Maschinen-Bewusstsein als Gefahr für die Menschheit

Denkt man diese Szenarien weiter, könnte es irgendwann durchaus intelligente Maschinen oder Roboter geben, die der Menschheit gefährlich werden könnten - entweder weil die Menschen dem Ziel, das der Maschine vorgegeben wurde, im Weg stehen, oder weil die Maschine ein eigenes Bewusstsein entwickelt, das die Unzulänglichkeit der Menschen erkennt oder Angst davor bekommt, dass die Menschen sich gegen sie wenden könnten.

Informatiker sind skeptisch

Informatiker selbst haben sich mit der Möglichkeit beschäftigt, was passieren würde, wenn eine KI entstünde, die intelligenter und mächtiger als die Menschen wäre. Von Alan Turing, einem Mathematiker, der in den 1940er und 1950er Jahren viele Grundlagen der Informatik gelegt hat, bis zum 2018 verstorbenen Astrophysiker Stephen Hawking haben viele Wissenschaftler sich mit den Gefahren einer übermächtigen KI beschäftigt.

Hawkings Befürchtung: Der Mensch kann nicht mehr mithalten

In einem Interview mit der BBC aus dem Jahr 2014 sagte Hawking, er fürchte die Konsequenzen, wenn eine Maschine geschaffen werde, die mit dem Menschen mithalten könne oder ihm überlegen sei. Sie würde sich aus sich selbst neu entwickeln und immer schneller neu gestalten. Der Mensch, der durch die langsame biologische Evolution eingeschränkt ist, könnte nicht mithalten und würde verdrängt werden.

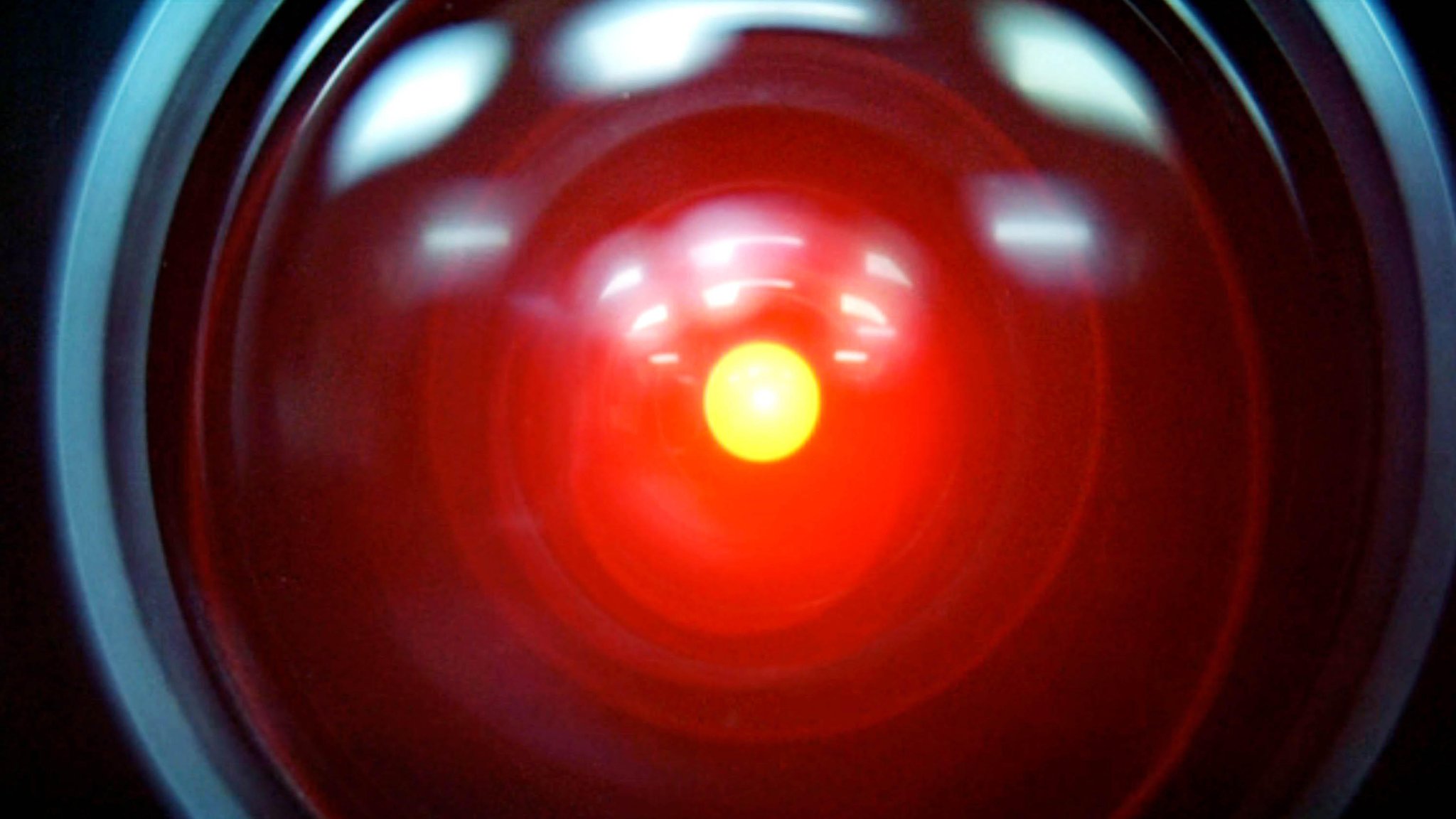

Viele Bespiele in Literatur und Film

Beispiele, wie dieser Konflikt in der Kulturgeschichte behandelt wurde, reichen von Frankenstein von Mary Shelley über den Computer HAL 9000 in Stanley Kubricks Film "2001: Odyssee im Weltall" und Arnold Schwarzenegger in der Rolle des "Terminator" bis zum bittersüßen Streifen "AI" von Steven Spielberg, der übermächtigen Illusionsmaschine in "Matrix" oder "I Robot" mit Will Smith. In diesem Film werden die drei Gesetze für Roboter, die der amerikanische Science-Fiction-Autor Isaac Asimov in seinem 1950 erschienen Buch "Ich, der Roboter" entwickelt hat, aufgegriffen.

Asimovs drei Gesetze: Erste Versuche von Alignment

Diese drei Gesetze beschreiben die Anfänge von Alignment. Denn sie sollen den Robotern Grenzen setzen, die die Menschheit vor Übergriffen durch Roboter bewahrt. Doch schon hier liegt die Schwäche in der Auslegung der moralischen Wertegrundlage. Denn wenn im ersten Gesetz festgeschrieben ist, "Ein Roboter darf einem menschlichen Wesen keinen Schaden zufügen oder durch Untätigkeit zulassen, dass einem menschlichen Wesen Schaden zugefügt wird", stellt sich sofort die Frage: Was genau ist "Schaden"? So ist beispielsweise der Schnitt, den der Arzt bei einer Operation durchführt, auch ein "Schaden" - selbst wenn er das Wohl des Menschen im Sinn hat.

Alignment: Annäherung an einen Moralkodex

Letztlich kann Alignment also immer nur eine Annäherung für einen moralischen Kodex sein, der aber letztlich genau die gleichen Schwächen hat, die ein moralischer Kodex auch bei Menschen hat: Eine entsprechend intelligente Maschine wird die Entscheidungs- und Wahlmöglichkeit in diesem Kodex erkennen und - ähnlich wie ihre Schöpfer - wird auch die KI sich dann immer nur für die in der jeweiligen Situation vermeintlich "gute" Seite entscheiden können - selbst wenn sich diese mit entsprechendem Abstand und je nach Betrachtungsweise im Nachhinein als "schlecht" oder "böse" herausstellt.

KI bisher nur Simulation von Intelligenz

Die Entwicklung eines wirklich intelligenten Systems könnte also unter bestimmten Umständen fatale Folgen für die Schöpfer einer solchen Maschine haben. Die allermeisten Experten gehen davon aus, dass es noch geraume Zeit dauern wird, bis die KI wirklich intelligent ist und nicht - wie heute noch - Algorithmen bestenfalls Intelligenz zu simulieren versuchen.

Sendung: Der KI Podcast in BR24 aktuell, Sonntag, 19. Mai ab 16.35 Uhr

Das ist die Europäische Perspektive bei BR24.

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!