Die Menge und Qualität von KI-generierten Inhalten auf Social Media verändert sich. Das wirkt sich auf Memes und Unterhaltungs-Content aus – und auf Desinformation. Das merken auch Faktenchecker: Das britische Faktencheck-Format "Fullfact" meldete vor kurzem eine nie dagewesene Menge an KI-Fakes. Das sei eine bedeutende Veränderung, schrieb der "Fullfact"-KI-Chef Andrew Dudfield auf Linkedin. Bis dahin hätten seinem Team aus dem Kontext gerissene Inhalte die meiste Arbeit gemacht.

Der #Faktenfuchs stellt fünf KI-Fakes vor, die exemplarisch für den aktuellen Stand der technischen Entwicklung stehen und zeigen, wie sie im Rahmen von Desinformation eingesetzt werden. Denn: Nicht immer geht es darum, fotorealistische Fakes zu produzieren, die man nicht als solche erkennt. Häufiger steht die Botschaft im Vordergrund.

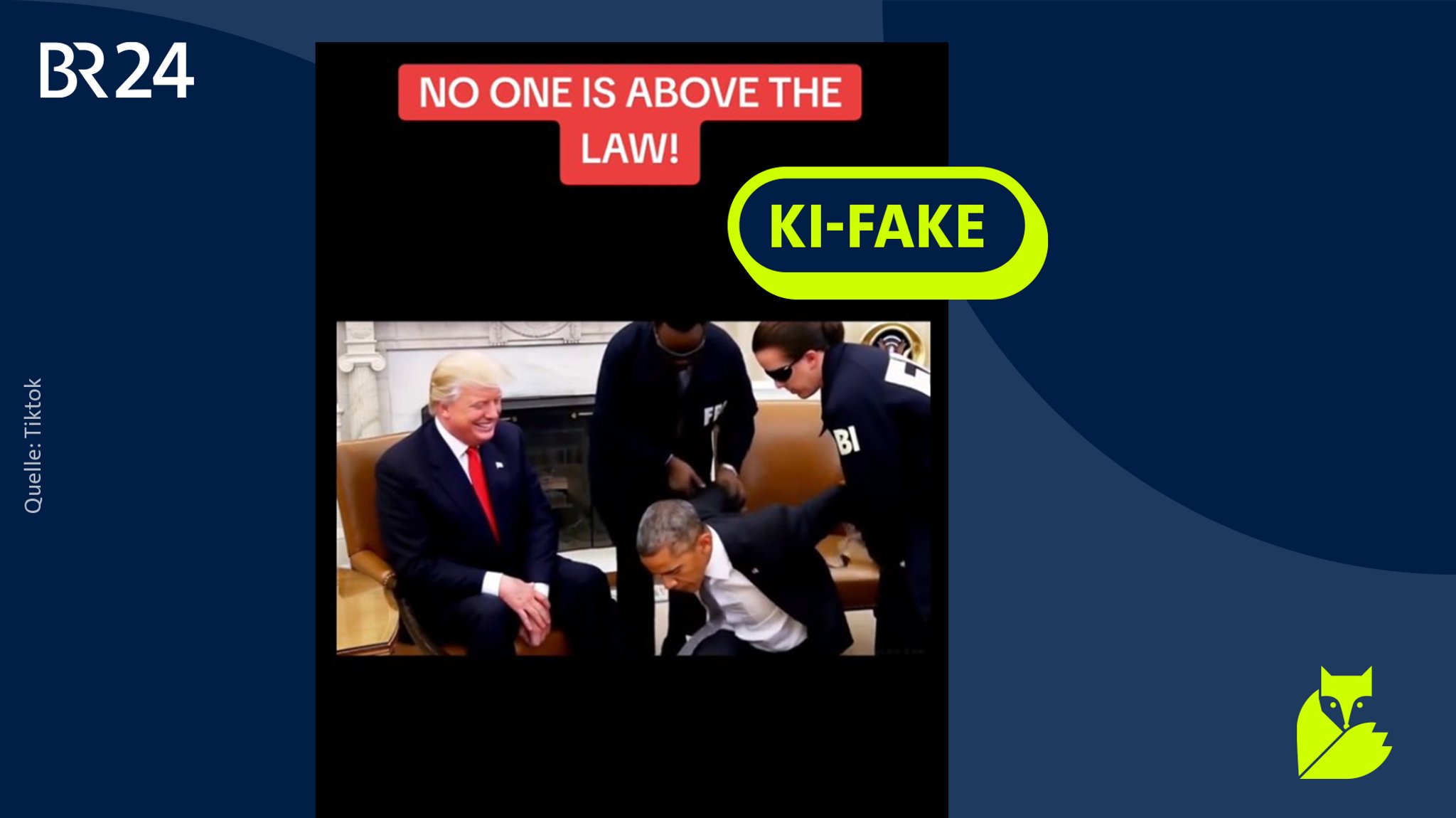

1. Trump teilt KI-Fake von Obama-Verhaftung - Experte spricht von "Shitposting"

Experte Holnburger nennt diesen KI-Fake einer vermeintlichen Obama-Festnahme einen "Shitpost". Grundlage ist ein echtes Video.

Im Juli teilte der US-Präsident ein Video, das eine mittels Künstlicher Intelligenz bearbeitete Sequenz enthält, in der es so aussieht, als legten FBI-Beamte Barack Obama im Weißen Haus Handschellen an.

Donald Trump sitzt lachend daneben, im Hintergrund läuft Trumps Wahlkampf-Soundtrack "YMCA" und über dem Video prangt der Text "No One is above the Law" (deutsch: "Niemand steht über dem Gesetz"). Im darauffolgenden Abschnitt des Videos ist ein KI-generierter Deepfake von Obama im Gefängnis zu sehen.

Neben komplett mittels KI erstellten Sequenzen ist die Quelle der angeblichen Obama-Verhaftung echtes Videomaterial. Es stammt aus dem Jahr 2017 und zeigt, wie der damalige Präsident Obama seinen designierten Nachfolger traf.

Echte Fotos und Videos als Ausgangsmaterial für KI-Fakes

Das Video, das zunächst auf TikTok kursierte, bekam große Aufmerksamkeit, nachdem Trump es auf seiner Plattform Truth Social geteilt hatte.

Josef Holnburger, Geschäftsführer und Political Data Scientist beim Thinktank "Center für Monitoring, Analyse und Strategie" (CeMAS), sagt: "Das bezeichnet man typischerweise als Shitpost" – also ein Posting, für das man sich wenig Mühe gibt, auf das man sich aber viele Reaktionen erhofft. "Da ist die Absicht gar nicht, einen möglichst täuschend echten Inhalt zu erzielen. Sondern da ist die Absicht, den Diskurs möglichst zu vergiften und ins Vulgäre zu ziehen. In diesem Fall leider mit Erfolg."

Das sieht Alexios Mantzarlis ähnlich. Er ist Direktor der Security, Trust and Safety Initiative an der Cornell Universität in New York. Mantzarlis sagt: "Ich glaube nicht, dass irgendjemand sich dieses Video anschaut und glaubt, dass Obama verhaftet wurde." Es sei Teil von Trumps Kommunikationsstil, alternative Realitäten mit KI-Videos darzustellen. Mantzarlis warnt davor, dass Menschen durch solche Videos abstumpfen.

Bei politischer Desinformation geht es häufig darum, bestehende Einstellungen zu bedienen und mittels KI-Fakes ideologische oder programmatische Ziele und Vorstellungen zu transportieren.

KI-Fakes wie dieses Video sind mittlerweile häufiger zu beobachten – was auch an der Verfügbarkeit entsprechender Tools liegt. Wie die "Washington Post" berichtet, können zahlende Google-User sich derartige Videoschnipsel über die Google-KI und deren Programm Veo 3 erstellen lassen.

Holnburger sagt: "Tatsächlich ist es relativ einfach, aus einem bestehenden Bild ein Video zu generieren." Mithilfe von Prompts – also Eingabebefehlen an das KI-Modell – könne man dann bestimmen, welche Szenen das Video darstellen soll. Solche Videos auf der Grundlage bestehender Bilder bergen die Gefahr, dass man sich vermeintlich erinnert und das Video deshalb eher für echt hält, erklärt Holnburger. Auch Mantzarlis sagt: "Diese Kombination ist sehr riskant."

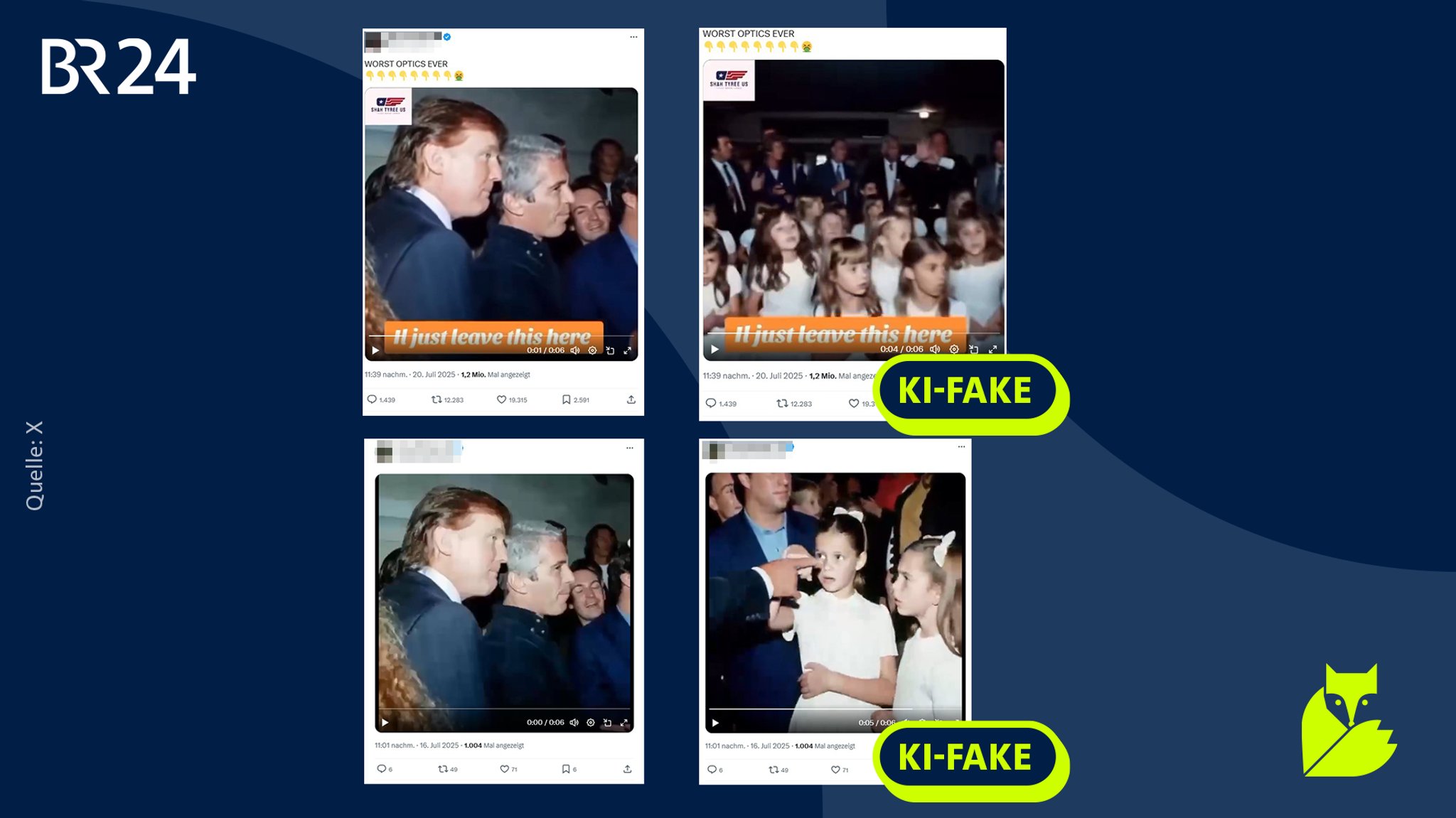

2. Aus echtem Material: KI-generierte Videos von Trump und Epstein

Auch diese Videos wurden mithilfe von KI auf der Grundlage echter Bilder generiert. Kontext sind die Spekulationen rund um die "Epstein Files".

Das zeigt sich auch an einem weiteren KI-generierten Video, in dem Donald Trump selbst Ziel des Fakes ist. Es geht um die Beziehung von Trump zum mittlerweile toten Sexualstraftäter Jeffrey Epstein und um die sogenannten "Epstein Files". So werden im Netz jene angeblichen Dokumente genannt, die Gerüchten zufolge belegen könnten, wer auf Epsteins Privatinsel zu Gast und möglicherweise in sexuellen Missbrauch involviert war.

Dass Trump und Epstein in den 1990er- und 2000er Jahren miteinander befreundet waren, belegen zahlreiche Medienberichte, darunter eine aktuelle Recherche der "New York Times".

Aus dieser Zeit gibt es auch authentische Foto- und Videoaufnahmen der beiden, etwa Videoaufnahmen des Fernsehsenders NBC oder Fotos, die im "New York Magazine" veröffentlicht wurden.

Ein Foto aus dem New Yorker Magazin zeigt Trump und Epstein auf einer Feier – und wird ebenfalls als Ausgangsbild für das Trump-KI-Video verwendet. Aus dem echten Foto generiert eine KI also eine gefälschte 'Verlängerung' dieses Materials.

Das Fake-Video von Trump und Epstein beginnt mit dem Ausschnitt des echten Fotos (in den Beispielen links) und schwenkt dann – hier beginnt der KI-Inhalt – nach rechts, wo junge Mädchen stehen. Der #Faktenfuchs hat zwei unterschiedliche Versionen gefunden, in denen einmal eine größere Gruppe junger Mädchen im Raum steht und einmal zwei junge Mädchen in unmittelbarer Nähe zu Trump. Beide Videos sind komplett künstlich generiert. Im zweiten Video ist das etwa anhand eines nicht durchgehenden Schattenwurfs zu erkennen.

Schnelle Erkennung von KI-Videos zunehmend schwieriger

Mit dem bloßen Auge sind diese Videos dennoch schwieriger als Fakes zu erkennen, als das Fake-Video von der Obama-Verhaftung. Mantzarlis sagt: "Die Videos versuchen wie alte Videos auszusehen, die zu der Zeit passen würden, in der sich Trump und Epstein getroffen haben." Es gebe auf visueller Ebene zumindest keine sehr offensichtlichen Anzeichen dafür, dass das Video gefälscht ist. KI-Fakes, die auf echtem Material aufbauen, hält Mantzarlis für besonders tückisch: "Wir haben früher bestimmte Elemente und Bilder als Ankerpunkte genutzt, um ihre Echtheit zu überprüfen – zum Beispiel ein Straßenschild, die Tageszeit oder ähnliches. Genau das wird bei solchen Videos und Bildern zunehmend schwieriger."

Auch der KI- und Verifikations-Experte Henk van Ess glaubt, dass mittlerweile "subtile" Fakes generiert werden, die besonders glaubhaft wirken: "90 Prozent des Materials ist korrekt, aber dann erscheint ein Politiker an einem Ort, an dem er nie war." Das könne es erschweren, solche Fakes zu erkennen.

Insbesondere außerhalb von Demokratien seien solche Fakes bereits ein größeres Problem, sagt van Ess. Dort gebe es, im Gegensatz zu Demokratien mit freier Presse, häufig keine leicht zugänglichen unabhängigen Quellen, anhand derer man verlässliche Informationen bekommen kann.

Insgesamt nimmt die Qualität KI-generierter Videos stetig zu. Holnburger sagt: "Da haben wir tatsächlich die Sprünge erlebt, die wir in den vergangenen Jahren eben auch bei Bildern und bei Chatbots erlebt haben." Insbesondere die Videos, die das Tool "Veo 3" von Google produziert, beeindrucken Holnburger. "Die bisherigen Modelle machen auf jeden Fall noch Fehler", sagt er, fügt aber an: "Es ist schwerer, die Fehler zu erkennen."

3. Fake-Reporter und KI-generierte Straßenumfragen nutzen Glaubwürdigkeit von Medien

Eine weitere derzeit zu beobachtende Entwicklung: Mit Veo 3 erstellte KI-Videos zeigen Fake-Reporter, die angeblich über ein wichtiges Ereignis berichten. Die Inhalte sollen durch diese Art des Fakes aufgewertet werden. Das sei angesichts des weltweit sinkenden Vertrauens in traditionelle Medien eine ironische Beobachtung, sagt Alexios Mantzarlis: "Man versucht die übrig gebliebene Glaubwürdigkeit zu nutzen, um seine Botschaften so zu verbreiten".

Wie "DW Fact check" recherchiert hat, kursierte etwa auf TikTok ein KI-generiertes Video einer angeblichen Reporterin, die auf einer Straße in London steht, während im Hintergrund Panzer vorbeifahren. Gerade im Zusammenhang mit Konflikten und Krisen sind solche KI-Nachrichten-Fakes vermehrt zu beobachten. Auch der #Faktenfuchs hat im Juni über einen KI-generierten Vlogger im Zuge des Israel-Iran-Konflikts berichtet.

Auf TikTok kursieren außerdem KI-generierte Videos von Straßenumfragen mit fremdenfeindlichen Untertönen, wie diese Recherche von "ZDF heute" zeigt.

Neben dem Versuch, den Inhalt aufzuwerten, sieht Josef Holnburger vom CeMAS auch noch einen anderen Grund für den Fake-Nachrichten-Trend: die Trainingsdaten. "Material von Nachrichtensendungen ist einfach grundsätzlich sehr viel in den Datensätzen vorhanden, mit denen diese Videomodelle trainiert wurden. Deswegen ist es auch so einfach, sowas relativ authentisch zu generieren."

Wie einfach so etwas mittlerweile möglich ist, hat der Verifikations- und KI-Experte Henk van Ess in einem Experiment auf seinem Blog "Digital Digging" gezeigt. In "einer Mittagspause", etwa einer halben Stunde, habe er einen solchen erfundenen Nachrichtenbeitrag generiert, erzählt er im Gespräch mit dem #Faktenfuchs. Das Skript habe er von einem KI-Sprachmodell erstellen lassen. Das Google-Programm Veo 3 machte ihm zufolge aus dem Skript dann die zugehörige Videosequenz, mit Bild und passendem Ton. Heraus kam ein in seinen Augen "glaubwürdiger politischer Skandal", so van Ess.

Der Beitrag sei auch von vielen Menschen geteilt worden, die ihn für echt hielten, erzählt van Ess. Die neuen Möglichkeiten der Videogenerierung hält er daher für gefährlich. Die Werkzeuge für potentiell schädliche Inhalte seien "nun wirklich in Reichweite von Verbrauchern".

4. Immer fotorealistischer: KI-generierte Bilder zu Air-India-Absturz

KI-generierte Bilder kann man häufig noch an Merkmalen wie hieroglyphenartiger Schrift erkennen. Diese Fehler werden aber weniger.

Auch im Bereich der KI-generierten Bilder entwickeln sich die Programme immer weiter. Neben dem qualitativen Fortschritt ist laut Josef Holnburger die Verfügbarkeit der benötigten Modelle enorm gewachsen. "Das führt natürlich dazu, dass es auch viel aktiver genutzt wird."

Das zeigt sich auch an einem Bild, das sich in Zusammenhang mit dem Absturz der Air-India-Maschine mit 260 Toten im indischen Ahmedabad, das sich auf X verbreitete.

Zu sehen sind Rettungskräfte, das Heck eines Flugzeuges, das aus einem teilweise zerstörten Gebäude ragt, und Trümmer. Auf den ersten Blick auffallende Fehler weist das KI-Bild nicht auf, ein Blick auf kleine Details ist nötig, um sie zu erkennen. So ist etwa die Vorderseite des Flügels gerade und die Rückseite abgeschrägt – in echt ist es andersherum. Außerdem wirkt die Schrift – sowohl auf dem Rumpf des Flugzeugs als auch auf den Uniformen der Rettungskräfte – hieroglyphenartig.

Verlassen könne man sich auf Fehler nicht, so Holnburger. "Es gibt nicht mehr die eine Maßnahme, bei der man erkennt, ob es ein KI-generiertes Bild ist oder nicht". Es gebe zwar immer noch Fehler, doch dafür müsse man das Bild eben genau anschauen – was angesichts der Bilderflut in den Sozialen Netzwerken häufig nicht mehr passiere.

- Tipps dafür, wie Sie KI-Inhalten nicht auf den Leim gehen, lesen Sie hier

5. Phänomen "AI Slop": KI-Inhalte fluten Soziale Netzwerke

Dieses Video ist ein Beispiel für "AI Slob". Es wurde vom TikTok-Nutzer, der es gepostet hat, sogar freiwillig als KI-generiert gekennzeichnet.

Die Flut an KI-Bildern- und Videos im Netz hat einen eigenen Namen: "AI Slop", was häufig als "KI Schlamm" oder "KI Müll" übersetzt wird. Immer mehr Menschen posten aufgrund der gestiegenen Verfügbarkeit und verbesserten Darstellung selbst KI-Inhalte. Alexios Mantzarlis sagt: "Wir ertrinken in unseren Informationsräumen in diesen minderwertigen Scheininhalten".

Mehr als 15 Millionen Menschen schauten sich zum Beispiel ein KI-generiertes Video von einem Buckelwal an, der ein Boot voller Touristen anspringt und zerstört.

Josef Holnburger sagt: "So etwas ist auch erst einmal völlig ungefährlich, weil es einfach etwas Neues ist, was auch ein bisschen zum Entertainment beiträgt." Dennoch können auch diese Inhalte schädlich werden, so Holnburger: "Der Übergang ist fließend. Viele Menschen denken, dass diese Inhalte doch irgendwie echt sind."

Mantzarlis glaubt: "Das ist das neue Normal." Auch Josef Holnburger sagt, die Relevanz von KI-Inhalten steige. "Es wird zunehmend schwerer, KI-Inhalte zu erkennen. Und natürlich steigt auch die Masse."

Logik beim Entlarven von KI-Inhalten bleibt wichtig

Deswegen bringe es nichts, darauf zu setzen, dass man ein typisches KI-Video an bestimmten Merkmalen wie der Anzahl der Finger erkennt. "Das kann in drei Monaten schon wieder überholt sein", so Holnburger. Lange Zeit hatten KI-Tools Schwierigkeiten damit, Finger korrekt darzustellen. Daher waren sie häufig ein offensichtliches Erkennungszeichen für KI-generierte Inhalte. Für die neuesten Tools stellt das inzwischen kein Problem mehr dar.

Dennoch sind Internetnutzer der Täuschung durch KI-generierte Videos auch zukünftig nicht hilflos ausgeliefert. Wichtiger werde bei der Betrachtung von Videos im Netz schlichte Logik, sagt Josef Holnburger: "Man muss sich immer die Frage stellen: Ergibt das Setting, in dem das gerade stattfindet, Sinn? Sind die Aussagen schlüssig?" Zudem könne man auf den Kontext achten, in dem ein Video veröffentlicht wurde: "Wer hat es produziert? Wer hat es herausgegeben?"

Widerspreche etwas einfacher Logik oder Erfahrungswerten, sollte man nochmal genauer hinschauen.

Experten besorgt über Umgang der Plattformen mit KI-Inhalten

Sowohl Mantzarlis als auch Holnburger blicken besorgt auf den Umgang großer Digitalkonzerne mit KI-Inhalten im Netz. Holnburger sagt: "Wir haben da einen Paradigmenwechsel bei den Plattformen wie Meta und X gesehen, wo einfach im Moment weniger Wert darauf gelegt wird, schadhafte Inhalte von einer Plattform zu entfernen und zu erkennen." Ein anderer Ansatz ist es, authentische, verifizierte Inhalte zu kennzeichnen. Diesen verfolgt zum Beispiel die Coalition for Content Provenance and Authenticity (C2PA), an der sich auch Google und Meta beteiligen.

Momentan werde die Relevanz von künstlicher Intelligenz für Desinformation im Netz häufig aber noch überschätzt, sagt Holnburger: "Viel Desinformations-Inhalt kann immer noch relativ einfach ohne KI produziert werden. Die gute alte Kachel mit falschem Zitat ist immer noch etwas, was für Desinformation eine riesige Rolle spielt."

Fazit

Auf den Social-Media-Plattformen kursieren derzeit KI-generierte Videos unter anderem von Barack Obama und Donald Trump, denen authentisches Material zugrunde liegt.

Es wird immer einfacher, realistische Bilder und Videos mithilfe von KI-Tools zu generieren. Experten rechnen damit, dass KI-Inhalte im Netz zukünftig weiter zunehmen werden. Fakes weisen häufig noch Fehler auf, diese nehmen aber immer weiter ab und werden weniger offensichtlich. Experten raten: Wer auch zukünftig KI-generierte Bilder und Videos erkennen will, sollte auf Logik, Kontext und Verbreiter achten.

Bei politischen Fakes gehe es außerdem nicht immer um täuschend echte Inhalte, hier stehe die Botschaft im Vordergrund.

Das ist die Europäische Perspektive bei BR24.

Quellen:

Interviews/Presseanfragen

Interview mit Alexios Mantzarlis, Direktor der Security, Trust and Safety Initiative bei Cornell Tech

Interview mit Henk van Ess, KI-Experte und Betreiber des Blogs "Digital Digging"

Interview mit Josef Holnburger, Political Data Scientist und Geschäftsführer beim "Center für Monitoring, Analyse und Strategie" (CeMAS)

Veröffentlichungen

BR24: Ursache für Air-India-Absturz mit 260 Toten gefunden

Digital Digging: My fake news experiment with Google's Veo3

DW Faktencheck: Wie erkenne ich KI-generierte Reporter?

Golem: Google beginnt bald mit Kennzeichnung von KI-Bildern

Indicator: A tentative taxonomy of AI slop

New York Magazine: Jeffrey Epstein: International Moneyman of Mystery

New York Times: A timeline of what we know about Trump and Epstein

Spiegel: Trump verbreitet Fakevideo, in dem Obama festgenommen wird

Tagesschau: Wie die Epstein-Akten für Trump zum Problem wurden

The Obama White House: President Obama Meets with President-Elect Trump

NBC News: Trump and Jeffrey Epstein: A detailed look at their relationship

Washington Post: Now you can turn a photo into an AI video with this Google tool

ZDF Heute: KI-Fake-Umfragen schüren Ressentiments

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!