Hinweis: Dieser Artikel entstand im Rahmen einer Kooperation von BR24 #Faktenfuchs, Deutsche Welle Faktencheck und ARD-Faktenfinder im Netzwerk ARD-Factchecking.

Darum geht's:

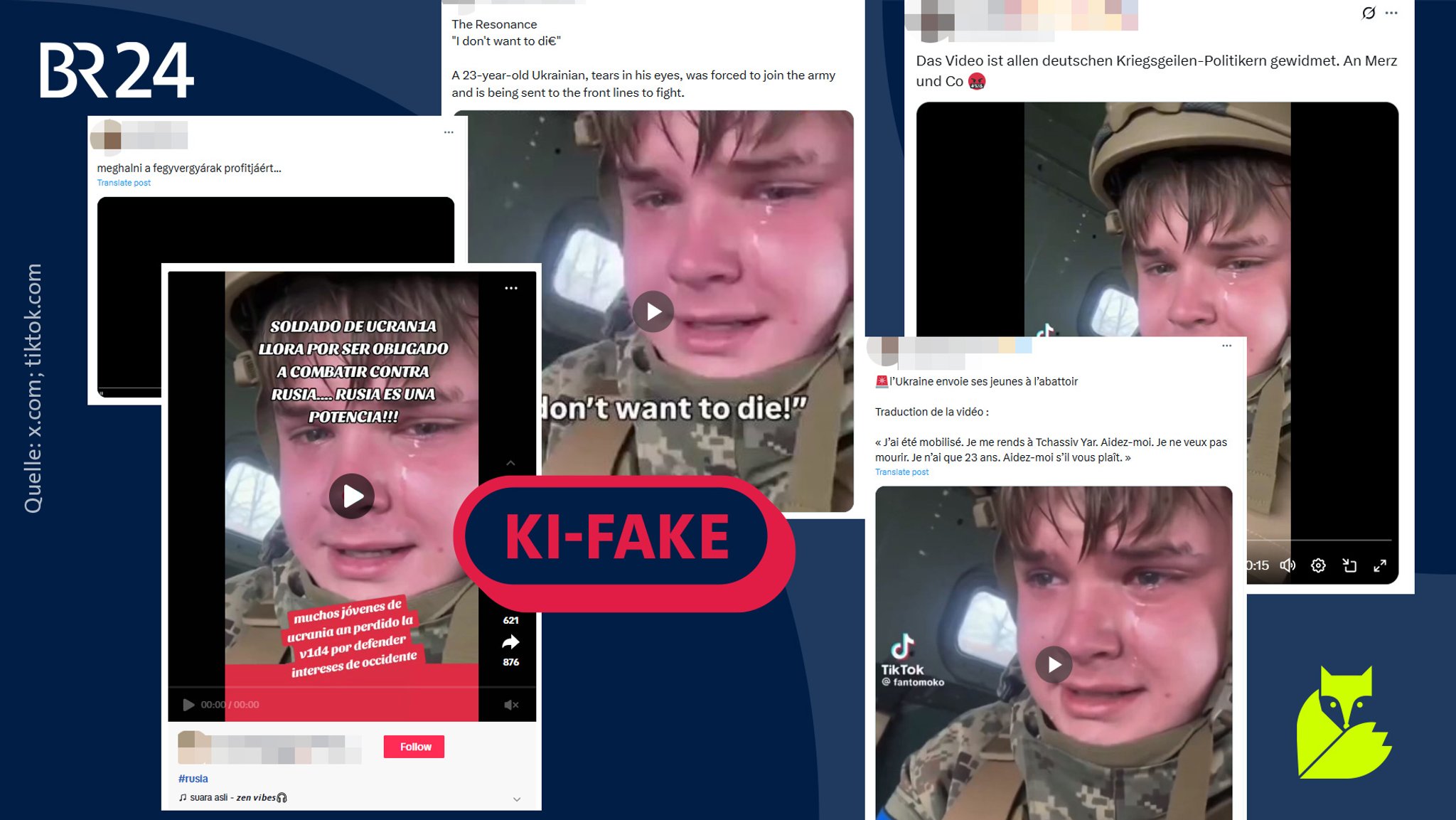

- Ein KI-Deepfake eines angeblichen ukrainischen Soldaten wird international verbreitet.

- Mithilfe von Fehlern im Bildmaterial und inhaltlichen Ungereimtheiten kann man das Video als KI-generiert erkennen.

- Laut der Ukraine verbreitet Russland zunehmend Propaganda über die Einberufung junger Menschen zur Armee.

Der junge Mann weint, als er in die Kamera spricht: "Ich wurde mobilisiert, ich fahre nach Tschassiw Jar. Helft mir, ich will nicht sterben". Der Mann trägt eine Militäruniform mit den Farben der ukrainischen Flagge auf dem Arm, Tschassiw Jar liegt im Verwaltungsbezirk Donezk im Osten der Ukraine. Er spricht auf Russisch, die Aussprache deutet auf einen Ukrainer hin. Doch das Video, um das es hier geht, ist sehr wahrscheinlich nicht echt.

KI-Fake wird international verbreitet

Das rund 15 Sekunden lange Video verbreitet sich international über Soziale Netzwerke wie X (ehemals Twitter), Tiktok oder Instagram. Auf X postet eine Userin das Video und schreibt dazu, sie widme es allen deutschen "Kriegsgeilen-Politikern". Mehr als 700.000 Mal wurde allein dieser Post laut der Plattform gesehen. Auch auf Englisch, Französisch oder Spanisch verbreiten sich Behauptungen dazu, ein ungarischer Post hat 1,8 Millionen Views.

Das ist ein KI-Deepfake: Ein Video, das angeblich einen weinenden ukrainischen Soldaten zeigt, bedient pro-russische Narrative.

Doch es gibt mehrere Hinweise darauf, die erkennen lassen, dass das Video mit KI erstellt oder zumindest mit KI bearbeitet wurde. Der #Faktenfuchs stellt sie in diesem Text vor.

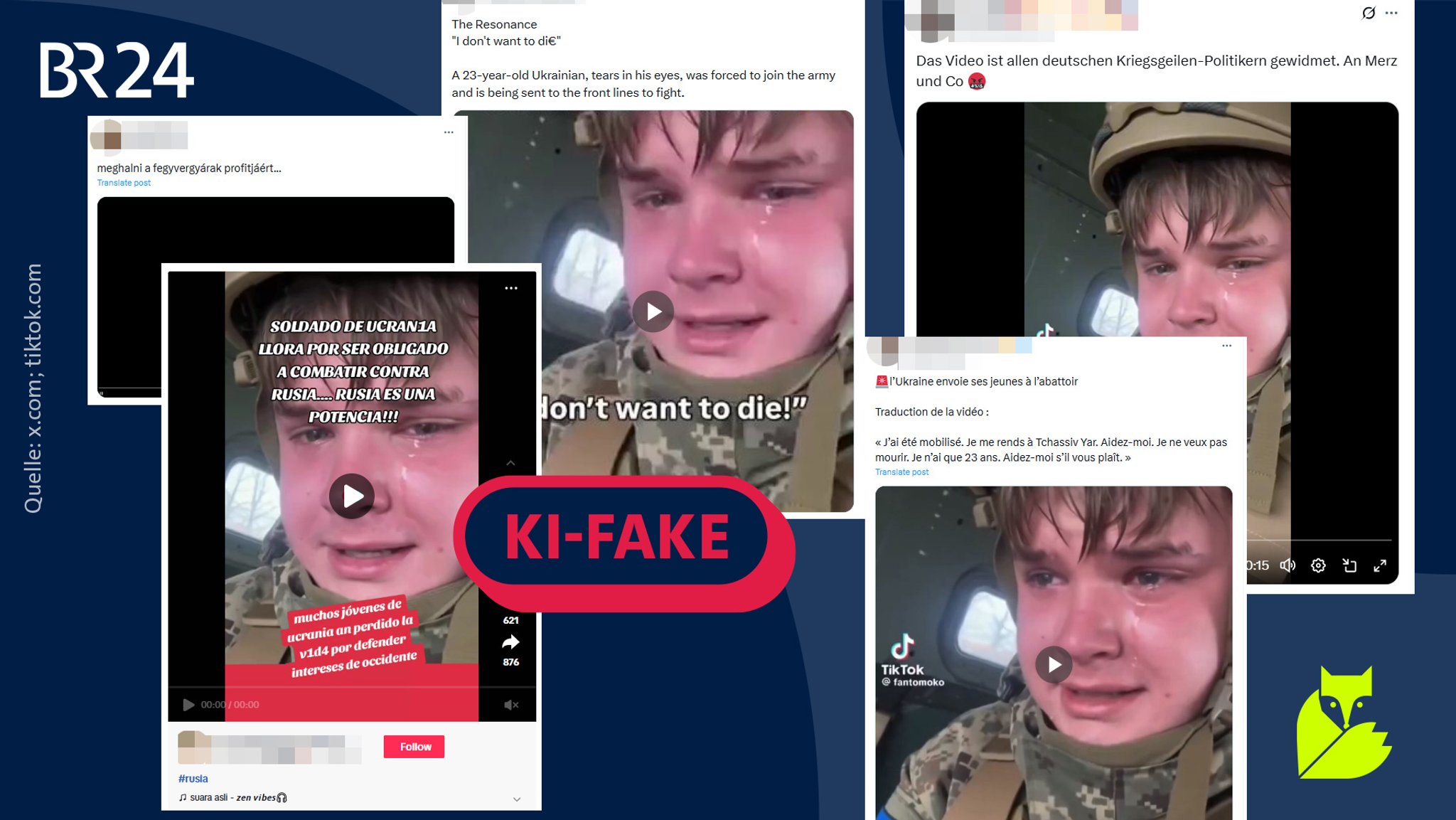

Hinweis 1) Bildfehler

Ein Hinweis auf KI-Einsatz in Videos sind Details, die sich entgegen Regeln der Physik fehlerhaft verändern. KI-Tools haben mit der sogenannten "Objektpermanenz" immer noch Schwierigkeiten – also der korrekten und gleichbleibenden Darstellung von Objekten in Bewegung. So ändern sich in KI-Videos oft unvermittelt Dinge wie Finger, Arme, Beine oder andere Dinge tauchen aus dem Nichts auf.

In dem fraglichen Video sieht man am Helm des Soldaten eine elliptische Platte, die dort scheinbar befestigt ist. Jedoch scheint sie an ihrem oberen Rand teilweise in den Helm überzugehen. Der noch stärkere Hinweis auf den Einsatz von KI ist, dass sich eine Wölbung in der Mitte der Platte verändert: Zuerst ist diese glatt und geschlossen, später ist sie in der Mitte abgesenkt, wie eine Schraubenmutter. Zwei weitere Fehler: Ein Leberfleck auf der rechten Wange des Soldaten erscheint unvermittelt. Außerdem verschwindet eine Naht auf der Schutzweste im linken Brustbereich auf einmal.

Das ist ein KI-Deepfake: Ein Video, das angeblich einen ukrainischen Soldaten zeigt, kann mit Bildfehlern als Fake identifiziert werden.

Generell ähnelt der Helm in dem Video nicht anderen Modellen, wie sie von der ukrainischen Armee verwendet werden. Auch Anatol Maier, Gründer des bayerischen Unternehmens Neuramancer, schreibt dem #Faktenfuchs nach einer Analyse: "Bei dem Video gehen wir davon aus, dass es sich mit hoher Wahrscheinlichkeit um ein vollständig KI-generiertes Video handelt."

Neuramancer ist auf die Erkennung von Deepfakes und KI-Manipulationen spezialisiert. Ein weiterer auffälliger Punkt ist laut Maier die Auflösung des Videos: Sie könnte darauf hindeuten, dass ein kleiner Teil des Videos abgeschnitten wurde – zum Beispiel um ein Wasserzeichen eines KI-Video-Programms zu entfernen.

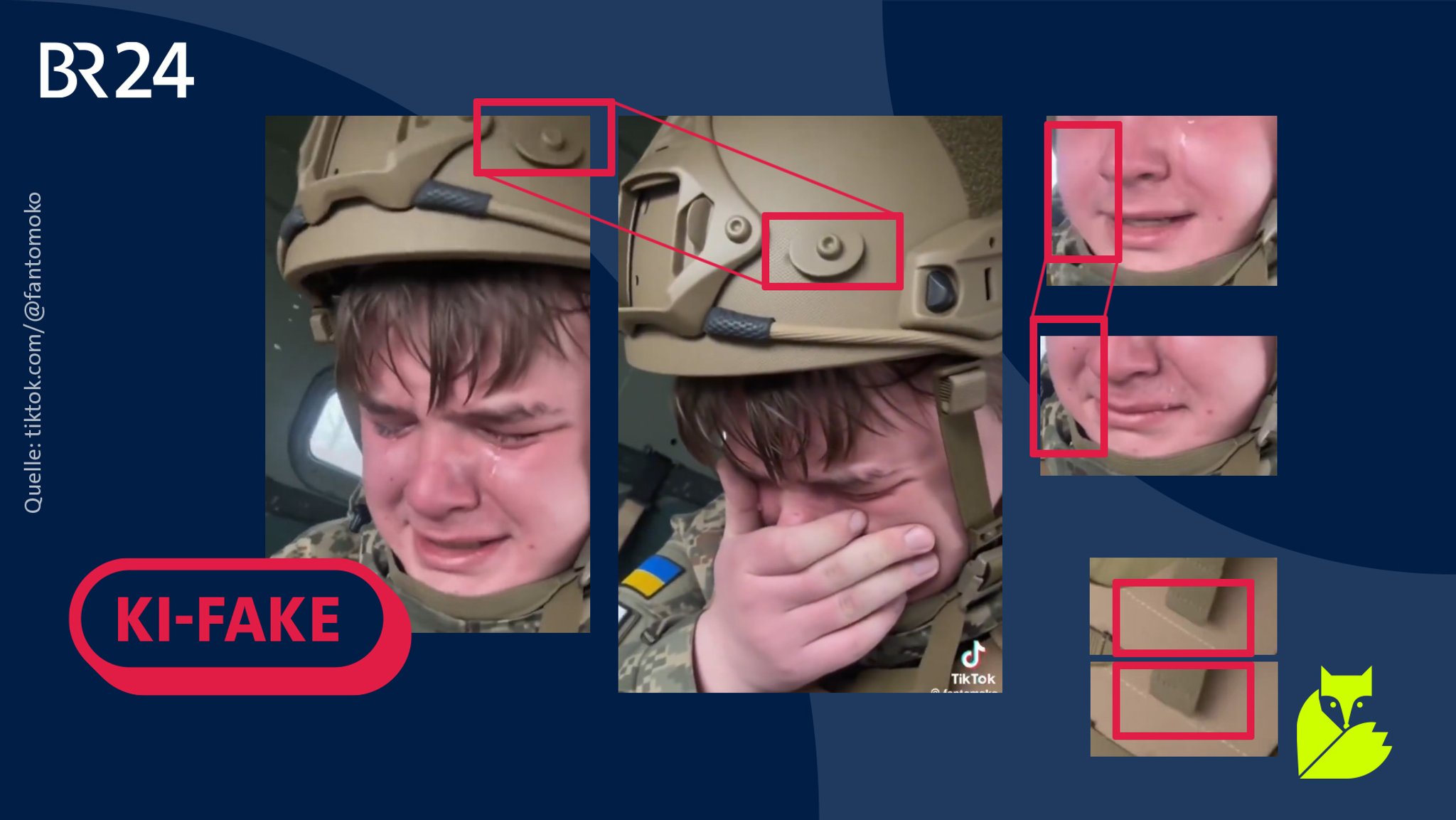

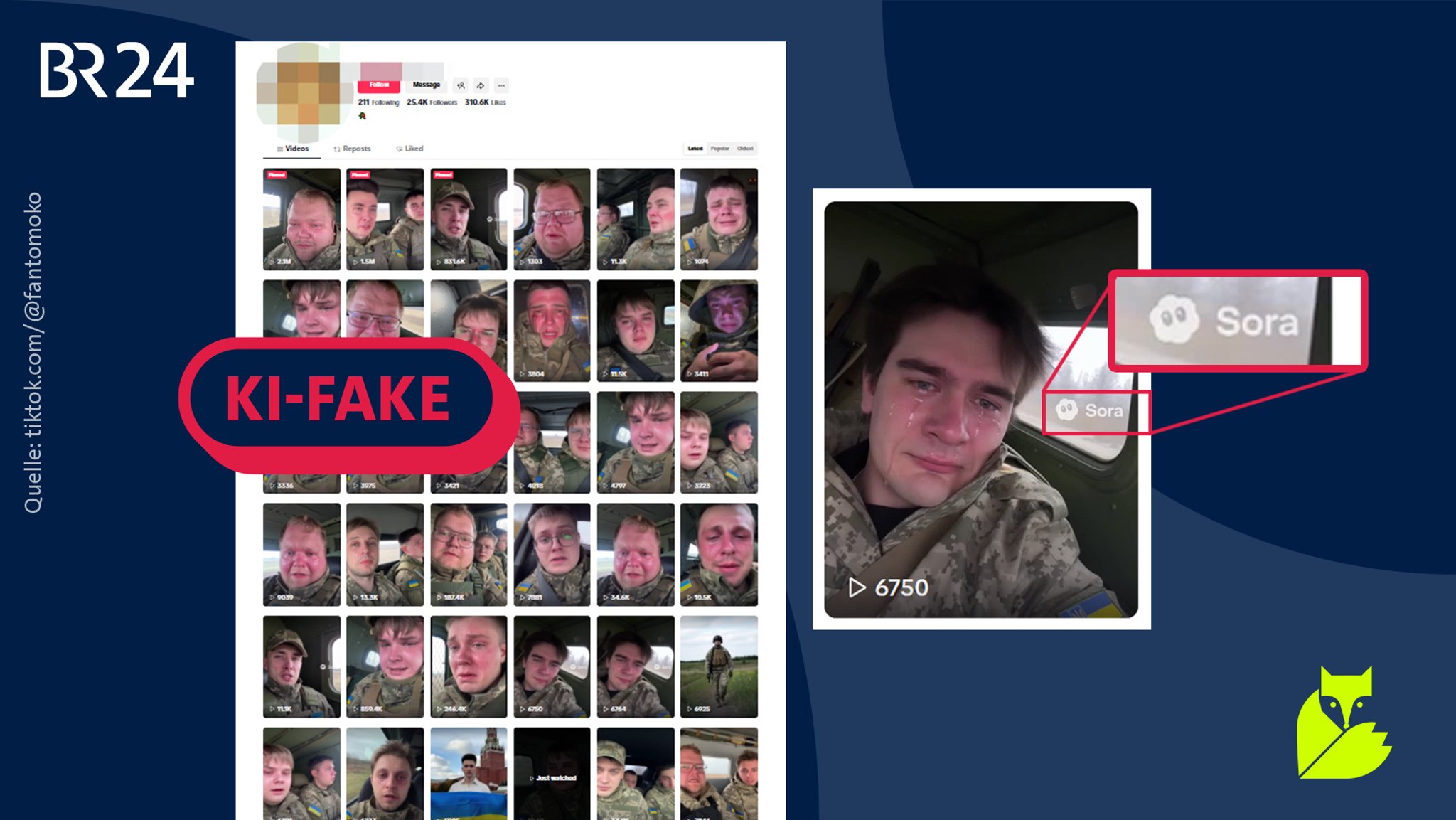

Hinweis 2) KI-Wasserzeichen auf Verbreiter-Account

Das Video und weitere ähnliche Videos sind über einen Account auf der Videoplattform TikTok verbreitet worden, bevor sie auf anderen Plattformen geteilt wurden. Das kann man über das TikTok-Wasserzeichen und den darin angegebenen Account-Namen nachvollziehen. Der Account existiert mittlerweile nicht mehr.

Über eine archivierte Version kann man aber nachvollziehen, dass diese Videos dort hochgeladen waren. Die Videos lassen sich zwar nicht mehr abspielen, man sieht aber die Vorschaubilder, die zum Großteil ähnliche Bilder zeigen: weinende Soldaten.

Ein Hinweis auf KI-Fakes ist, dass auf mindestens sieben der Vorschaubilder ein Wasserzeichen des KI-Videoerstellungsprogramms "Sora" von OpenAI zu sehen ist. Andere Videos, die dieser Account veröffentlichte, wurden also mit KI erstellt. In Sora gibt man einen Text ein, den die KI als Grundlage nimmt, um ein Video zu erstellen.

Videos, die angeblich ukrainischen Soldaten zeigen, können anhand eines Wasserzeichens als KI-generiert erkannt werden.

Hinweis 3) Alter des "Soldaten"

In dem Video behauptet die Person, sie sei 23 Jahre alt und "mobilisiert" worden. Das ist eine inhaltliche Ungereimtheit. Die Ukraine zieht nach eigenen Angaben derzeit erst Männer ab 25 Jahren in die Armee ein. Jüngere Männer können sich freiwillig melden, was sie teilweise auch tun.

Dem ARD-Studio Kiew sind keine Fälle von Zwangsmobilisierungen von Unter-25-Jährigen bekannt, schreibt es auf #Faktenfuchs-Anfrage. Die Behauptung, dass die Ukraine junge Menschen unter der Altersgrenze einziehe, werde zunehmend von der russischen Propaganda benutzt, so das ukrainische Center for Countering Disinformation, eine Abteilung des Nationalen Sicherheits- und Verteidigungsrat der Ukraine.

Hinweis 4) Ähnlichkeiten mit russischen Personen

Die Person in diesem Video weist eine Ähnlichkeit mit einem russischen Mann auf, der unter dem Pseudonym "Kussia88" Videos im Internet veröffentlicht. Auf seinem Telegram-Kanal hat er schon auf diese Vermutungen reagiert und eine Beteiligung daran weder direkt zugegeben noch dementiert.

Das ukrainische Center for Countering Disinformation teilte in einem Statement mit: "Das Gesicht in dem Video gehört zu einem russischen Bürger, nicht einem Ukrainer."

Ein zweites Gesicht, das in den Videos des TikTok-Accounts als "Soldat" auftauchte, war das eines Putin-Kritikers. Er teilte der Deutschen Welle mit, er habe "absolut keine Verbindung" zu diesen Videos. "Alle davon wurden von jemandem mit KI generiert, ohne meine Zustimmung oder mein Dazutun". Die Videos würden russische Propaganda-Narrative bespielen, sagte der Mann der DW.

Fazit

Das Video eines angeblich 23-jährigen ukrainischen Soldaten, der zur ukrainischen Armee eingezogen wurde, weist inhaltliche Ungereimtheiten und Bildfehler auf, mit denen man den Einsatz von Künstlicher Intelligenz erkennen kann. Der TikTok-Account, der das Video veröffentlichte, hatte auch diverse andere KI-generierte Videos hochgeladen.

Quellen:

Interviews/Presseanfragen

Anfrage bei Anatol Maier, Neuramancer AI Solutions

Anfrage beim ARD-Studio Kiew

Fact check: Videos of crying Ukrainian soldiers are fake, dw.com, 10.11.2025

Fake "Ukrainian soldier" deepfake exposed, Center for Countering Disinformation auf x.com, 04.11.2025

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!